1 引言

随着现代网络与多媒体的快速发展,图像的应用已成为生活中不可或缺的一部分。但是,由于拍摄环境条件差,如雨天[1]、雾天[2]、夜间[3]、逆光[4]等,造成采集图像中的景物出现可见度降低、颜色退化等问题。为提高这些低质图像的可用性,需对其进行增强处理。本文主要针对逆光图像的增强问题开展研究。逆光图像产生的原因是被拍摄物体恰好处于光源与捕获设备之间。由于逆光,采集图像背景亮度远远高于被摄主体(如行人、车辆等),进而造成图像有意义的区域可视质量降低。

常见的逆光图像增强技术可分为两类[5]:全局与局部处理的方法。基于全局的图像增强技术主要包括:对数变换、 β函数变换[6]及直方图均衡化[7- 8](Histogram Equalization,HE)等。其中,直方图均衡化最为典型,它利用灰度的统计特征,将原始图像的灰度分布从较为集中的区间映射到整个灰度区域均匀分布,从而达到图像增强的目的。Fu等人基于颜色统计提出的颜色估计模型[9] (Color Estimation Model,CEM),可以提高低照度图像的亮度,恢复图像的细节与颜色信息。但是,在图像灰度分布不均匀的情况下,通过全局增强的图像会出现局部区域增强不足的问题。

不同于图像的全局增强,局部增强方法则利用图像局部区域像素点相关性较大的性质,在一定程度上克服了全局增强方法对图像局部区域的亮度增强不足的问题。常见的局部处理方法包括Retinex算法[10-11]与平均保持双直方图均衡[12](Brightness Preserving Bi-Histogram Equalization,BBHE)等。Retinex系列算法包括单尺度Retinex[10](Single Scale Retinex,SSR)和多尺度Retinex[11](Multi-Scale Retinex,MSR)等。经过SSR增强的图像虽然可以恢复细节与颜色信息,但增强性能极易受到尺度参数的影响。在SSR的基础上,为降低尺度对增强性能的影响,MSR对不同的尺度分配不同的权重。因此,基于MSR增强的图像拥有较好颜色保真度与较高的压缩能力。BBHE根据原图的灰度均值将输入图像分割成两个子图像,然后对两个子图像分别进行均衡化处理,以达到保持图像亮度的目的。但是,局部增强方法在增强图像的同时也易于放大噪声,造成边缘模糊的问题。

综合上述对全局与局部区域增强方法的分析,本文提出一种融合全局与局部区域亮度的逆光图像增强方法。为避免CEM模型对局部暗区的过度增强导致的“虚化”现象,提出了亮度保持的颜色估计模型(Brightness Preserving Color Estimation Model,BPCEM)。此外,针对全局增强与局部区域增强方法间的平衡问题, 通过引入图像局部块信息熵,有效地实现它们之间的自适应融合。

2 逆光图像增强算法流程图

图1为本文提出的逆光图像增强算法流程。该流程主要由三部分组成:1)图像全局增强:基于逆光图像的全局统计特性,通过CEM模型对图像进行整体亮度增强,同时保持图像的细节信息;2)图像局部区域增强:对经过分割后得到的图像亮区与暗区分别采用BPCEM模型进行局部增强,在保持亮度的同时,避免过度增强导致的虚化问题;3)图像融合:通过引入局部块信息熵,实现全局增强与局部增强的自适应融合,从而改善逆光图像的光照质量。最后利用双边滤波器对融合后的图像进一步滤波以减少噪声影响。

图1 逆光图像增强算法流程图

Fig.1 The proposed framework for backlit image enhancement

3 基于颜色估计模型的图像全局增强

颜色估计模型[9] (Color Estimation Model,CEM)是Fu等人提出的一种映射方法,它可以将较小的灰度值映射为较大的灰度值,从而提高图像的整体亮度。对于逆光图像I,通过CEM增强后得到的图像IGE为:

(1)

这里, fCEM(I)为单调映射函数。对于CEM模型,fCEM(I)有如下形式:

(2)

其中,λ为调节参数(参考文献[9],本文取值:1.33),MI为图像I的灰度均值。

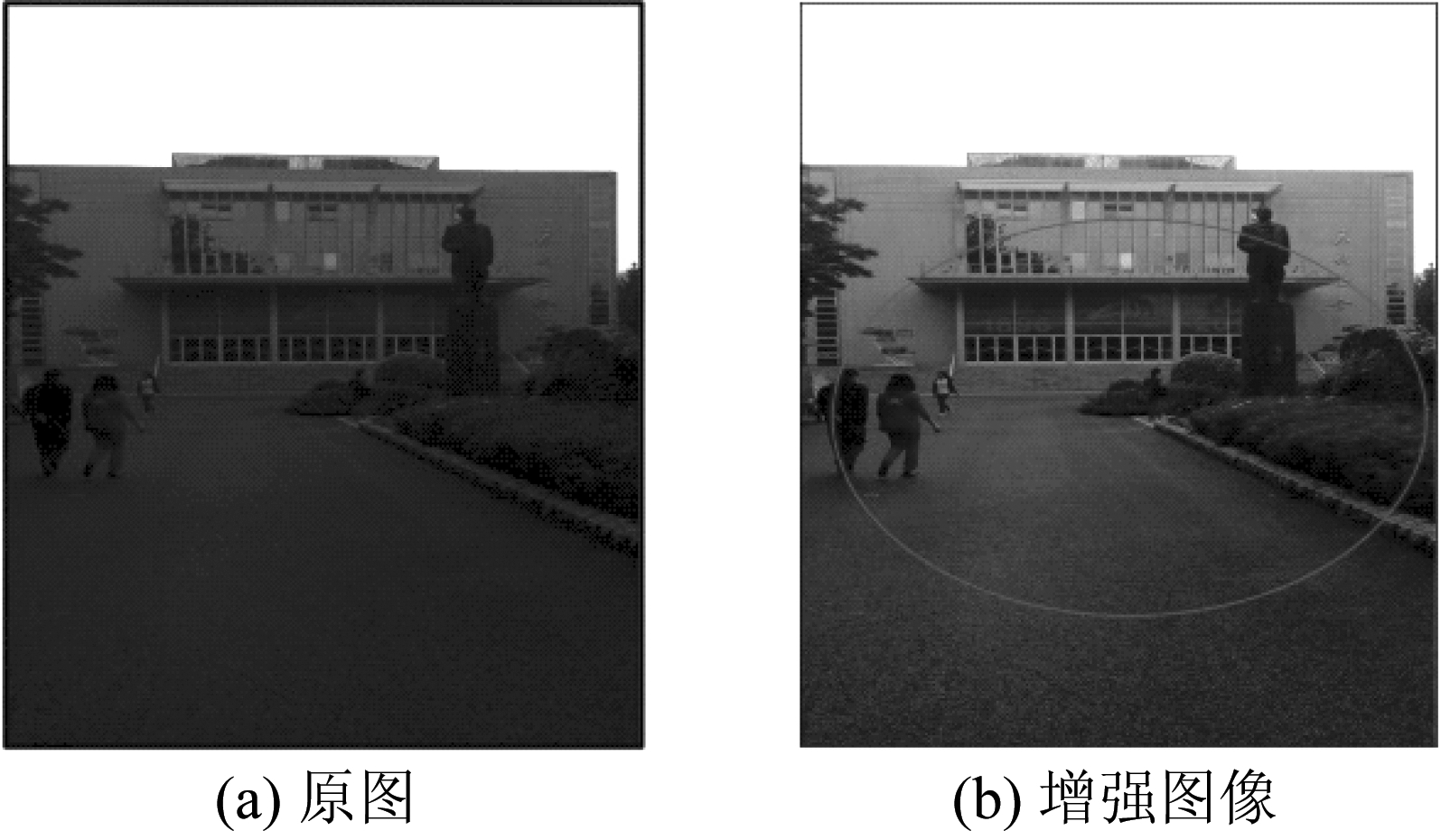

图2所示为通过CEM对逆光图像进行全局增强的结果。从图中可以看出,利用CEM对逆光图像(图2(a))进行全局增强,可以提高输入图像的整体亮度,恢复图像的颜色与细节信息。但是,在图像较暗区域(图2(b)的红色圆圈标记区域),其增强效果并不理想。

图2 基于CEM模型的全局图像增强

Fig.2 CEM based global image enhancement

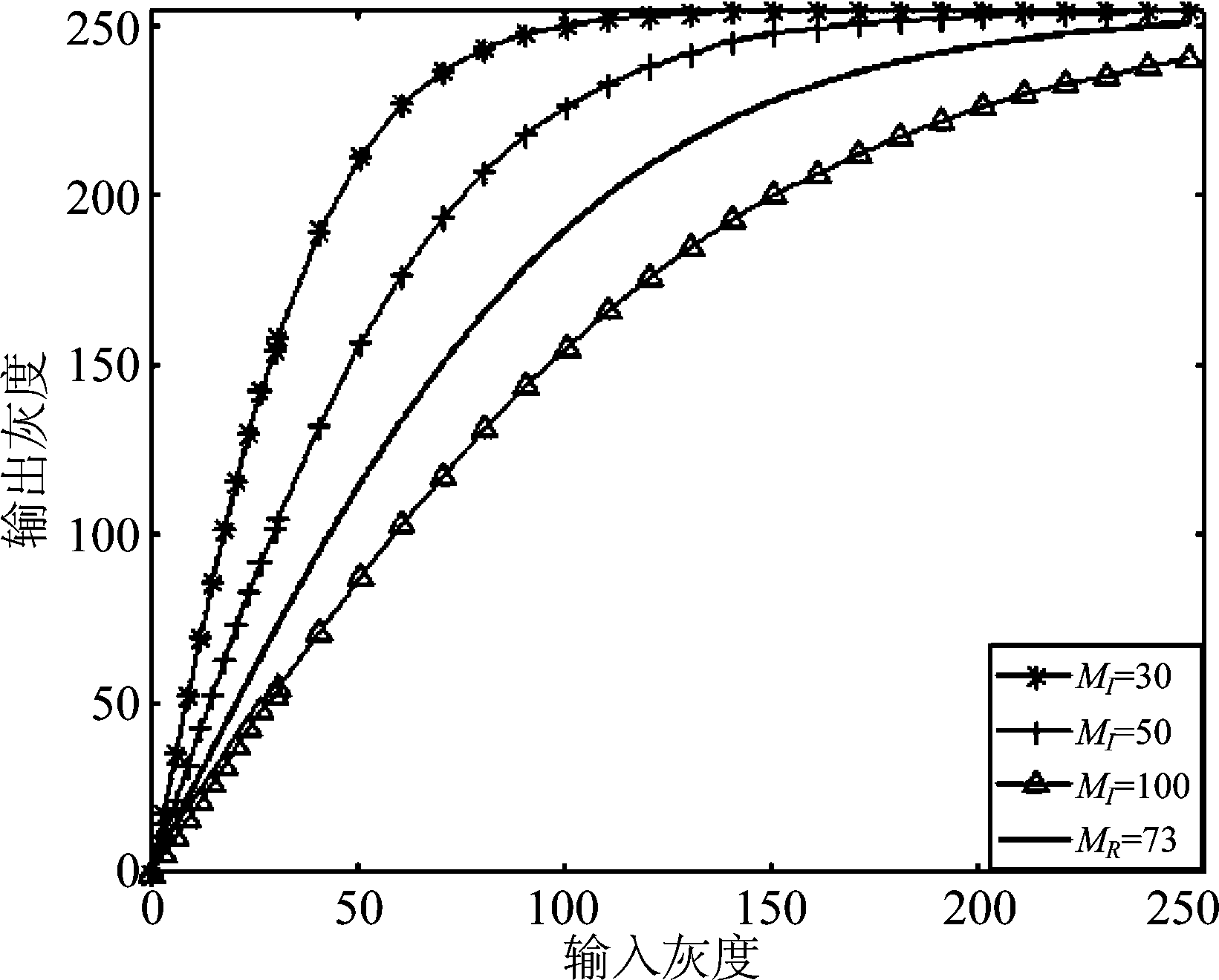

通过分析CEM模型可以发现,逆光图像的增强质量受到图像灰度统计均值MI的影响。图3为不同均值对应的增强曲线,从中可以看出灰度均值越大,图像的增强幅度反而越小。其中,纯黑曲线为针对图2(a)R分量的增强曲线。

4 基于亮度保持的图像局部区域增强

当逆光图像中存在局部较亮区域时(如图2(a)的天空),由于整幅图像的均值偏大,导致增强后图像的较暗区域的亮度增强不足(如图2(b))。为此,本文引入局部暗区增强思想。

图3 不同均值对应的CEM增强曲线

Fig.3 Family of CEM curves for varying mean values

4.1 局部暗区提取

逆光会使拍摄图像的局部区域亮度降低。然而,在逆光图像中,行人、车辆等目标通常位于图像较暗的区域。针对该现象,本文引入“亮区”与“暗区”概念。顾名思义,“亮区”为逆光图像中灰度值较高的区域,一般情况下为背景;“暗区”为逆光图像中灰度值较低的区域,此区域主要包含被摄主体。通常,“暗区”可被视为有意义的区域。

基于以上分析,本文采用如下方式提取逆光图像的“暗区”:

(3)

其中,x∈I为逆光图像的像素点;上标D表示“暗区”,B表示“亮区”;T为灰度值门限(本文中,T取值为80)。图4所示为逆光图像暗区的提取结果。

图4 暗区提取效果图

Fig.4 Dark region extraction of backlight image

4.2 亮度保持的颜色估计模型

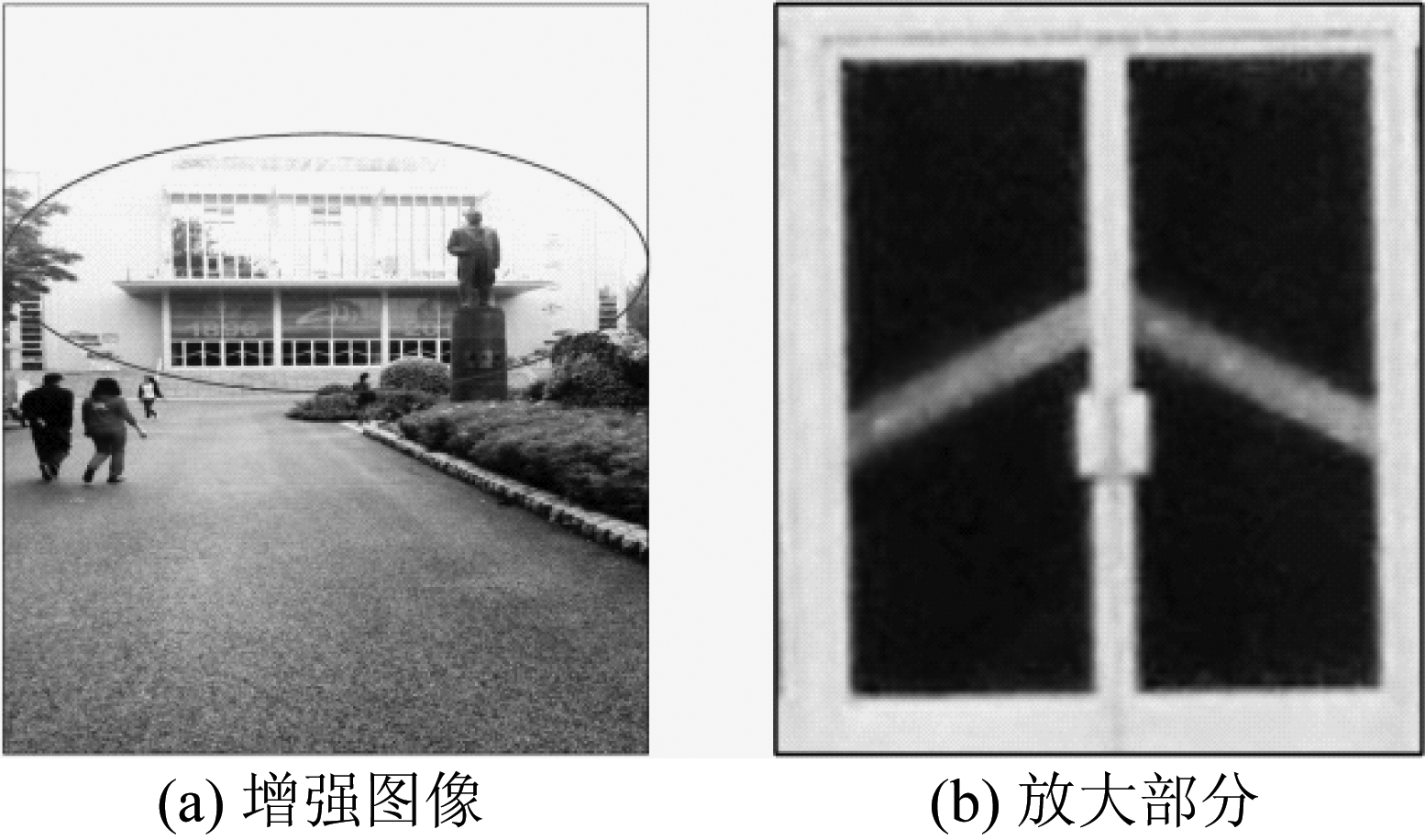

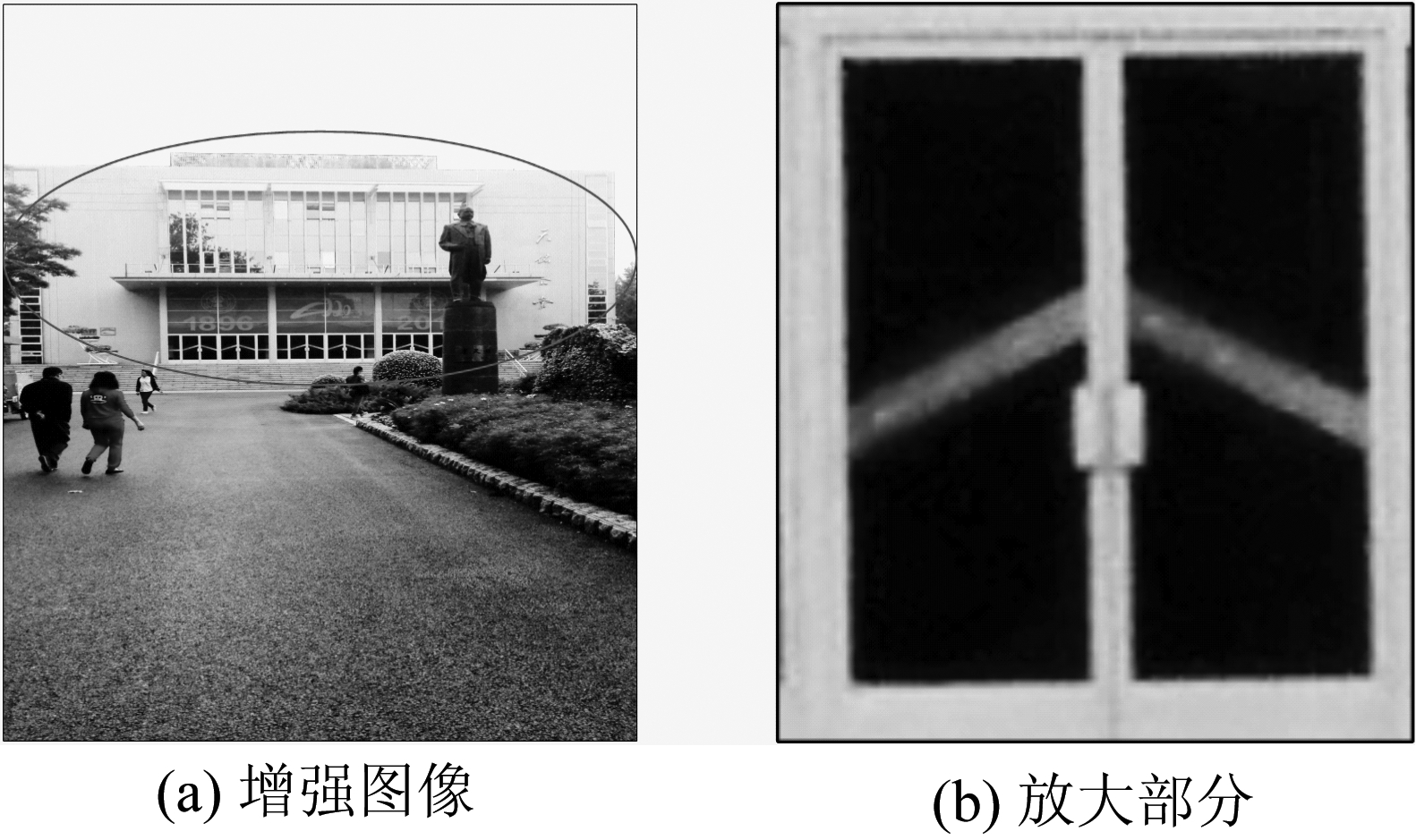

如图5所示,对于逆光图像的亮区与暗区,当利用CEM模型对其进行基于局部统计的增强时,图像的暗区亮度得到明显提高,但同时呈现“虚化”的现象(图5(a)),尤其图中红色圆圈标记区域出现边缘模糊的问题。图5(b)是图5(a)标记区域局部块的放大结果,从中可以看出,过度增强后图像“虚化”现象非常明显。

图5 基于CEM的局部区域增强效果图

Fig.5 CEM based local region enhancement

为改善CEM模型对局部暗区增强性能的不足,本文提出亮度保持的颜色估计模型(Brightness Preserving Color Estimation Model,BPCEM),即对公式(1)中的fCEM(I)进行修正:

(4)

其中, μ为调节参数,ML为局部暗区ID或亮区IB的灰度均值。

进一步,结合公式(1)与(4)可得到应用fBPCEM(I)对图像进行局部区域增强后的图像ILE:

(5)

图6是映射函数f(I)对暗区R分量值的映射曲线以及相应的对其增强后的变化曲线。可以看出,虽然fCEM(I)与fBPCEM(I)具有相似的变化趋势,但是fBPCEM(I)衰减更慢,尤其在灰度值较低的区段更加平缓。相应地,BPCEM模型在灰度值较低的区段表现出更加平缓的增强性能。

图7是基于BPCEM对逆光图像进行局部区域增强后的结果。通过对比图5(b)与图7(b)可以看出,使用BPCEM模型增强后的图像比CEM模型具有更好的视觉质量,没有出现CEM模型导致的“虚化”现象。图8给出了针对图5(b)与图7(b)中暗区R分量的统计直方图。不难发现,BPCEM的R分量值多集中于较低的区段,且含有更多的灰度值分量。上述分析表明,BPCEM模型在不损失图像细节的同时,能够有效保持局部区域亮度保真度,避免了CEM模型的过度增强问题。

图6 针对暗区R分量的映射函数f(I)特性曲线与增强特性曲线

Fig.6 Analysis on f(I) and enhancement performance for R component of dark region

图7 基于BPCEM的局部区域增强

Fig.7 BPCEM based local region enhancement

图8 增强图像R分量直方图

Fig.8 R component histograms of enhanced image

5 基于局部块信息熵的自适应图像增强融合

综合上述对逆光图像全局与局部区域增强的分析,图像全局增强可以恢复图像的细节信息,而图像的局部区域增强可以提高图像的整体亮度。为使处理图像兼具全局与局部区域增强的优点,本文提出了基于图像局部块信息熵的自适应融合方法。

为了使融合图像符合人类的视觉特性,图像的自适应融合过程选择在HSV颜色空间进行。图9给出了图像融合的具体过程:首先,对获得的全局与局部区域增强图像进行彩色空间变换到HSV颜色空间,提取各自的V分量图像;然后,对各自的V分量图像进行块划分;在此基础上,计算各局部块信息熵实现全局与局部区域增强图像的自适应融合;最后,对融合后的V分量以及全局增强图像的H与S分量进行彩色空间转换到RGB颜色空间,得到融合图像。

具体来说,全局与局部区域增强图像的融合采用如下方式:

(6)

其中,IE为融合后的增强图像,N为图像分块的数目,![]() 与

与![]() 分别为局部区域与全局增强图像的第i个子块,wil与wig分别为对应子块图像的权值。为确保融合后得到的增强图像既能获得经过全局增强后图像的细节信息,同时保持局部区域增强后图像的亮度,如何自适应选取公式(6)中的权值wil与wig则变得非常重要。

分别为局部区域与全局增强图像的第i个子块,wil与wig分别为对应子块图像的权值。为确保融合后得到的增强图像既能获得经过全局增强后图像的细节信息,同时保持局部区域增强后图像的亮度,如何自适应选取公式(6)中的权值wil与wig则变得非常重要。

图9 基于局部块信息熵的自适应图像增强融合

Fig.9 Adaptive image fusion based on block entropy

信息熵是用来衡量图像含有信息量丰富程度的重要指标,信息熵越大表明图像含有的信息量越大。假设图像中像素点的灰度值是相互独立的样本,信息熵表示灰度分布的聚集特征,则图像信息熵可以公式(7)表示:

(7)

其中n为灰度级,pi为图像灰度值为i的概率值。

为使融合图像尽可能地保持信息熵较大的局部块特征,本文采用如下权重分配方式:

(8)

其中,Eig、Eil为对应子块图像的信息熵。

6 实验结果与分析

为验证本文算法的性能,在多幅不同场景的低质图像上进行了测试,并与CEM[9]、HE[7]、BBHE[12]、SSR[10]以及MSR[11]等算法进行比较。评价指标为峰值信噪比(Peak Signal to Noise Ratio,PSNR)与信息熵。

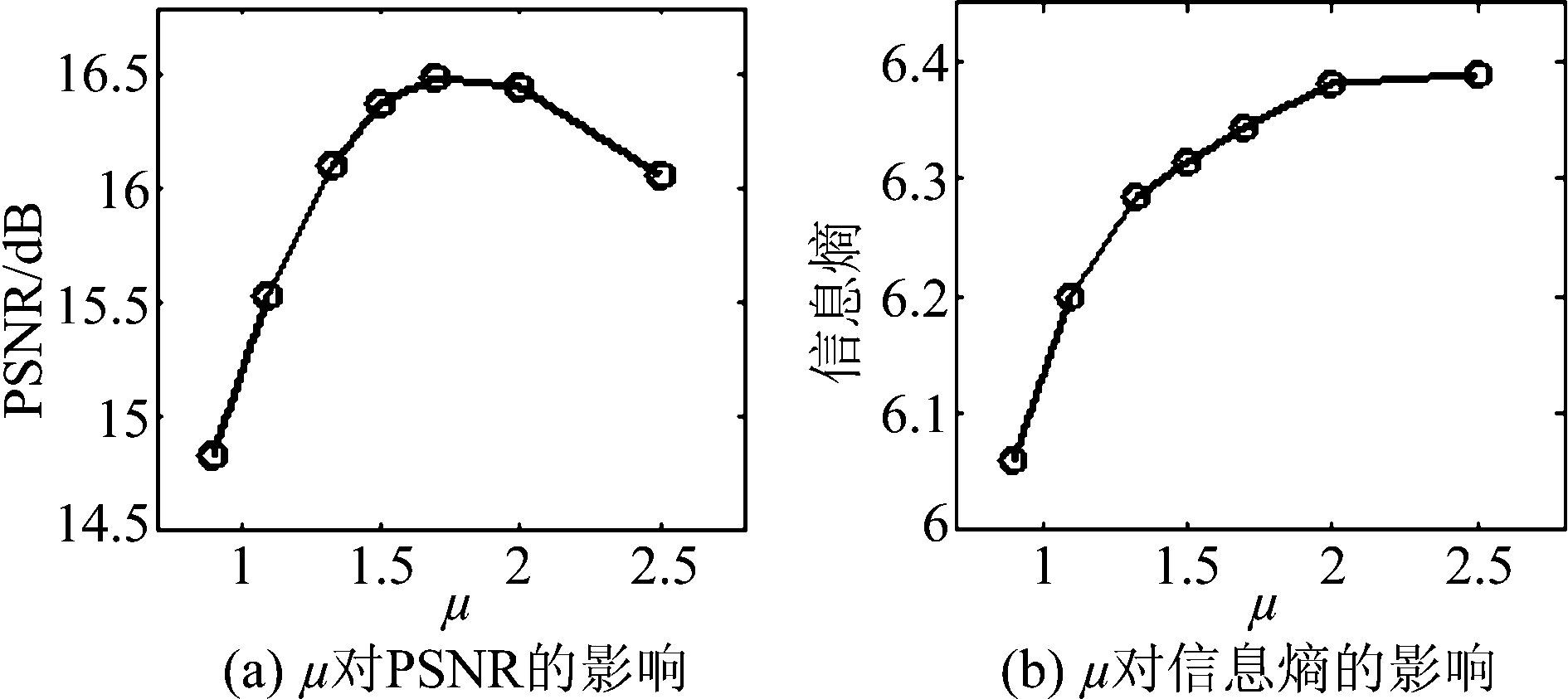

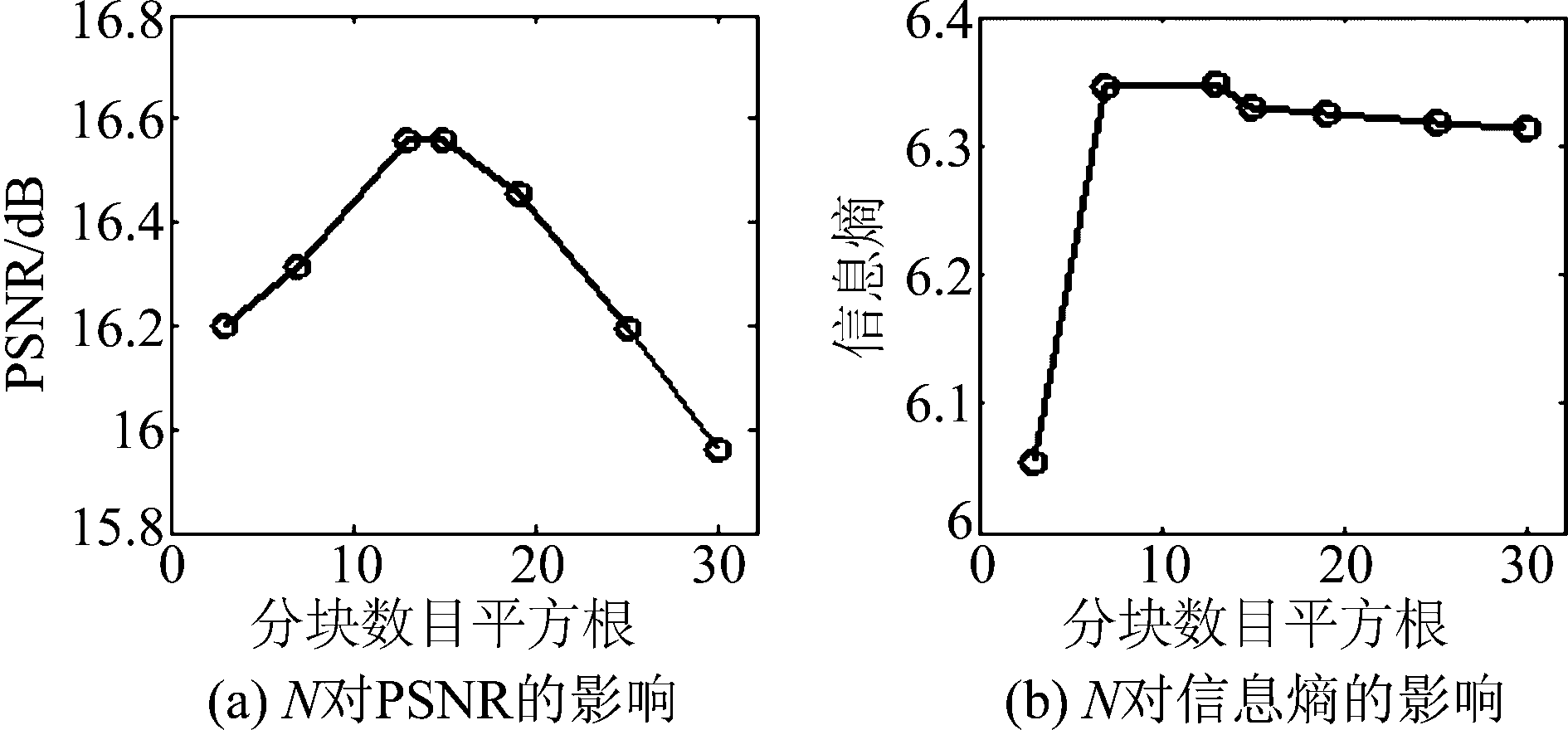

6.1 参数μ与分块数目N的确定

如上文所述, μ与N分别为BPCEM模型的调节参数与图像融合的分块数目。对于两个参数的选取,图10与图11分别给出了两个参数的变化对融合图像PSNR与信息熵的影响。从图中可以看出,当μ取值在1.5~1.7之间、N取值为152时,图像的PSNR与信息熵相对较高。因此, μ在1.5~1.7取值,参数N设置为152。

图10 参数μ对融合图像的影响

Fig.10 Effects of parameters μ on fused image

图11 参数N对融合图像的影响

Fig.11 Effects of parameters N on fused image

6.2 图像增强性能分析

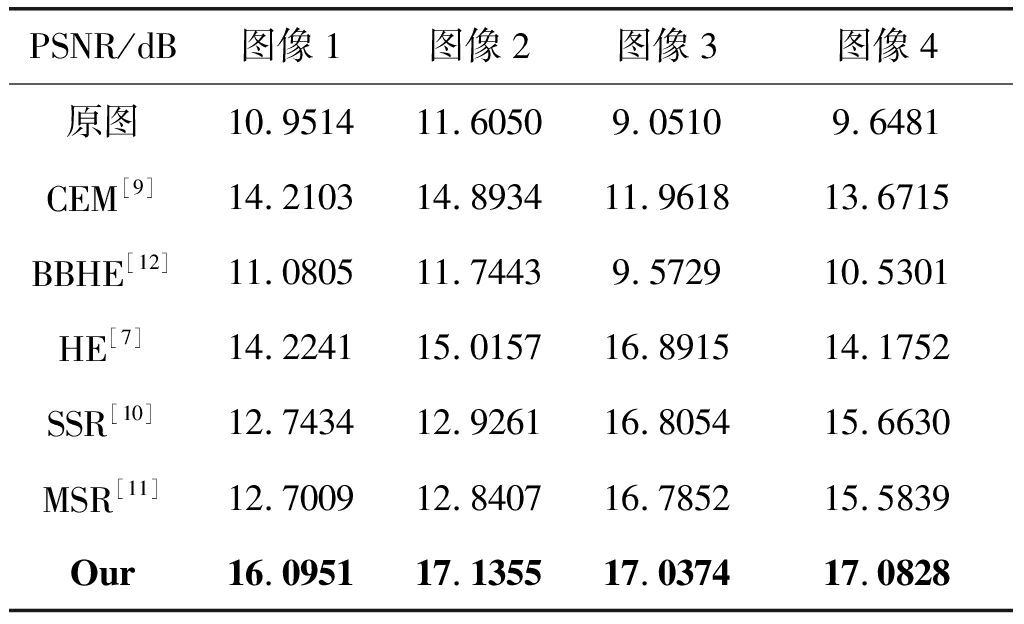

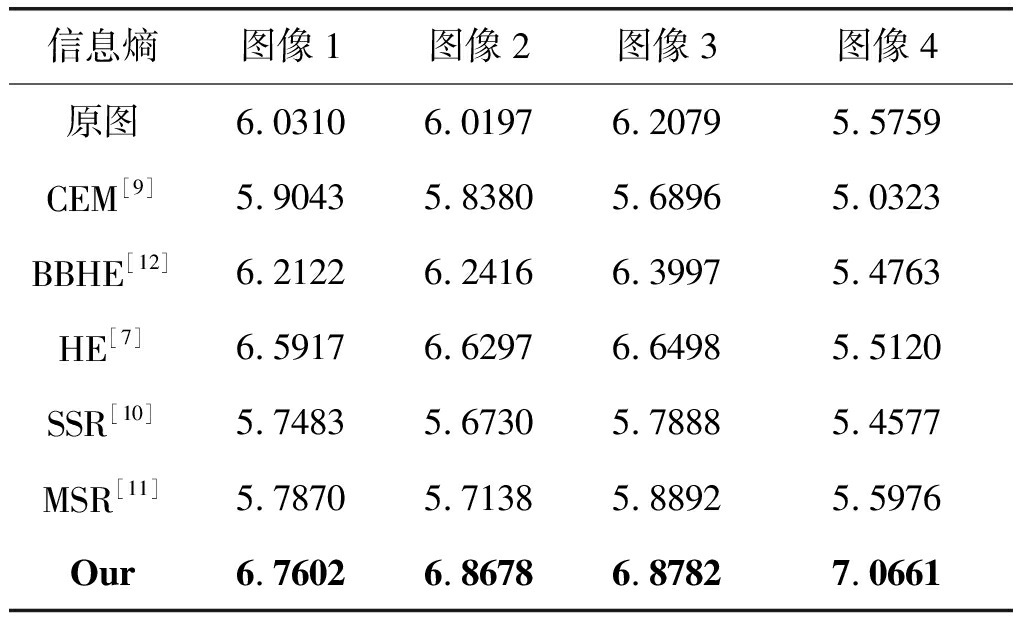

表1与表2为通过本文算法与其他算法进行增强后图像的PSNR与信息熵值。通过表1的PSNR值与表2的信息熵值可以看出,CEM模型与HE算法的增强性能比较稳定;其他算法则对于不同的图像,增强性能表现有所不同;本文算法增强的图像PSNR值与信息熵值相对较高,性能相对比较稳定。

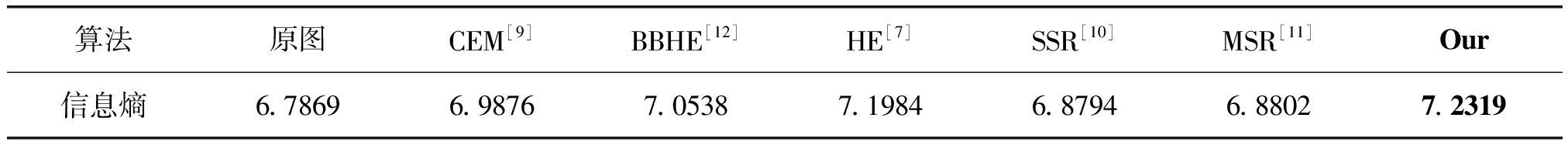

为了测试本文算法处理不同场景图像的有效性,本文还对Pece[13]提供的低照度图像数据集进行了实验。由于Pece[13]数据集并没有给出对应的高质量图像,实验部分仅给出了增强图像的信息熵值,如表3所示。从中可以看出,本文算法相比于比较算法平均信息熵更高,可以提供更多的信息。

表1 不同算法增强图像的PSNR值

Tab.1 PSNR values of enhanced images with different methods

PSNR/dB图像1图像2图像3图像4原图10.951411.60509.05109.6481CEM[9]14.210314.893411.961813.6715BBHE[12]11.080511.74439.572910.5301HE[7]14.224115.015716.891514.1752SSR[10]12.743412.926116.805415.6630MSR[11]12.700912.840716.785215.5839Our16.095117.135517.037417.0828

表2 不同算法增强图像的信息熵

Tab.2 Entropy of enhanced images with different methods

信息熵图像1图像2图像3图像4原图6.03106.01976.20795.5759CEM[9]5.90435.83805.68965.0323BBHE[12]6.21226.24166.39975.4763HE[7]6.59176.62976.64985.5120SSR[10]5.74835.67305.78885.4577MSR[11]5.78705.71385.88925.5976Our6.76026.86786.87827.0661

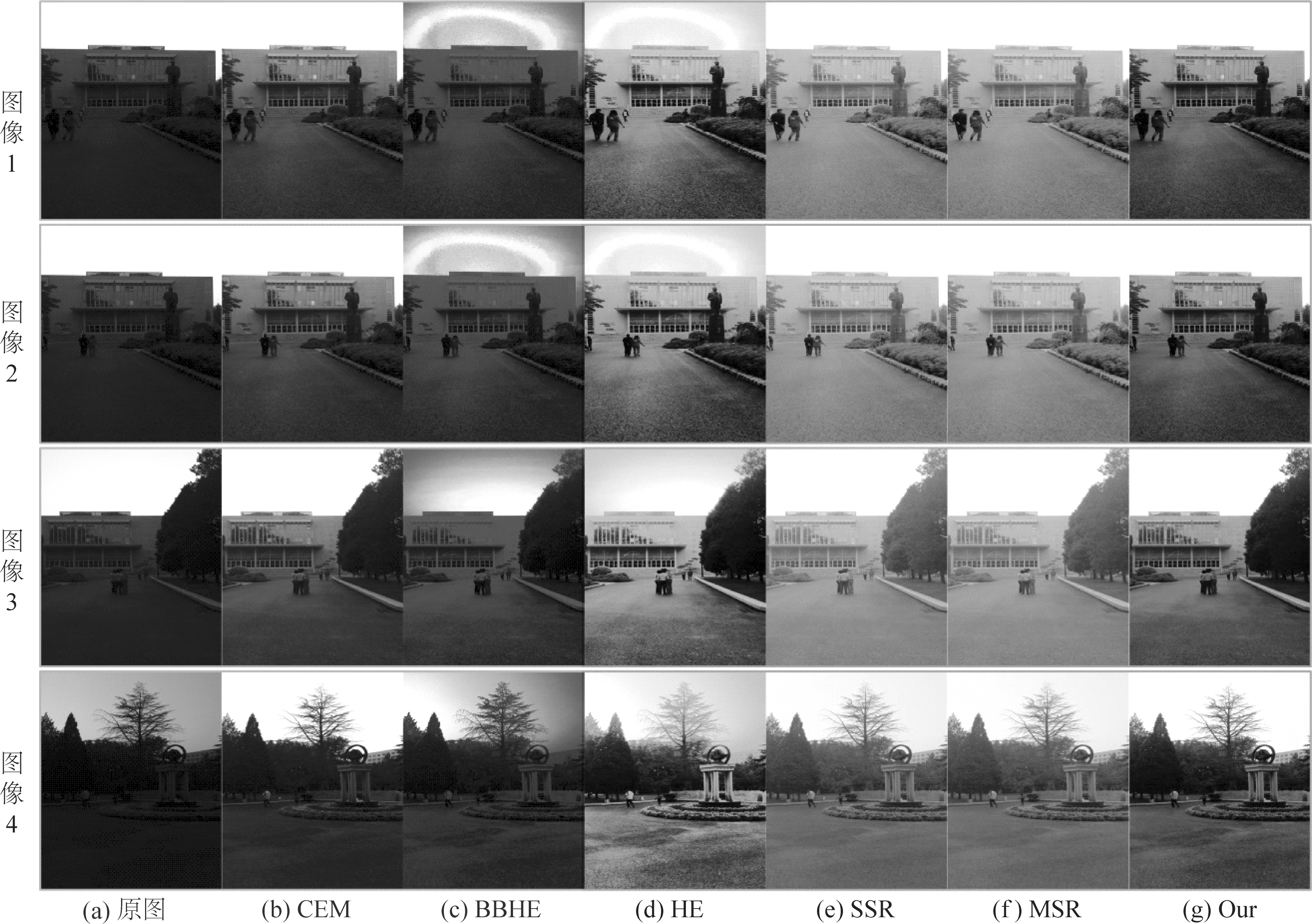

6.3 基于主观视觉的性能比较

从视觉效果上,图12与图13给出了本文算法与其他算法对低质图像增强的效果图。从中可以看出,CEM、BBHE与HE算法增强的图像会出现局部区域增强不足的现象,以及局部区域颜色映射错误的问题。此外,SSR与MSR增强的图像会出现边缘虚化的问题,同时受噪声的影响非常明显。本文算法可以避免局部区域增强不足的缺陷,提高输入图像的亮度,同时恢复图像的细节与颜色信息。

表3 利用本文算法与其他算法对Pece数据集进行增强的图像平均信息熵

Tab.3 Average entropy of our method and other enhancement methods on Pece database

算法原图CEM[9]BBHE[12]HE[7]SSR[10]MSR[11]Our信息熵6.78696.98767.05387.19846.87946.88027.2319

图12 本文算法与其他算法增强效果图Fig.12 Results of our method and other enhancement methods

图13 本文算法与其他算法对Pece数据集的增强效果图Fig.13 Results of our method and other enhancement methods on Pece database

7 结论

本文提出了一种融合图像全局与局部区域亮度的逆光图像增强算法。利用颜色估计模型对逆光图像进行全局增强,恢复图像的细节信息。为保持逆光图像暗区的亮度,同时避免局部区域增强后的“虚化”现象,提出了局部亮度保持的颜色估计模型。此外,针对全局与局部区域增强的平衡问题,提出了基于图像局部块信息熵的自适应融合方法。

参考文献

[1] Chen Duanyu, Chen Chiencheng, Kang Liwei. Visual Depth Guided Color Image Rain Streaks Removal Using Sparse Coding[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2014, 24(24):1430-1455.

[2] Li Yu, Tan R T, Brown M S. Nighttime Haze Removal with Glow and Multiple Light Colors[C]∥Proceedings of the IEEE International Conference on Computer Vision, Santiago, Chile, 2015:226-234.

[3] Guo Xiaojie, Li Yu, Ling Haibin. LIME: Low-Light Image Enhancement via Illumination Map Estimation[J]. IEEE Transactions on Image Processing, 2017, 26(2):982-993.

[4] Huang T H, Shih K T, Yeh S L, et al. Enhancement of Backlight-Scaled Images[J]. IEEE Transactions on Image Processing, 2013, 22(12):4587- 4597.

[5] 许欣. 图像增强若干理论方法与应用研究 [D]. 南京:南京大学, 2010.

Xu Xin. Research on Image Enhancement Methods and Applications [D]. Nanjing: Nanjing University, 2010. (in Chinese)

[6] 陈喆, 蒋羽超, 殷福亮. 利用β函数映射与帧间信息融合的低照度视频图像增强方法[J]. 信号处理, 2013, 29(12): 1632-1637.

Chen Zhe, Jiang Yuchao, Yin Fuliang. Low Contrast Video Enhancement with Illumination Nonlinear Mapping and Interframe Information Fusion[J]. Journal of Signal Processing, 2013, 29(12): 1632-1637. (in Chinese)

[7] Zimmerman J B, Pizer S M, Staab E V, et al. An Evaluation of the Effectiveness of Adaptive Histogram Equalization for Contrast Enhancement[J]. IEEE Transaction on Medical Imaging, 1998, 7(4):304-312.

[8] Tsai C M, Yeh Z M. Contrast Enhancement by Automatic and Parameter-Free Piecewise Linear Transformation for Color Images[J]. IEEE Transactions on Consumer Color 2008, 54(2):213-219.

[9] Fu Huiyuan, Ma Huadong, Wu Shixin. Night Removal by Color Estimation and Sparse Representation[C]∥Proceedings of International Conference on Pattern Recognition. Tsukuba, Japan, 2012: 3656-3659.

[10]Jobson D J, Rahman Z, Woodell G A. Properties and Performance of a Center Surround Retinex[J]. IEEE Transactions on Image Processing, 1997,6(3): 451- 462.

[11]Rahman Z, Jobson D J, Woodell G A. Multi-Scale Retinex for Color Image Enhancement[C]∥Proceedings of International Conference on Image Processing. Lausanne, Switzerland, 1996: 1003-1006.

[12]Kim T K, Paik J K, Kang B S. Contrast Enhancement System using Spatially Adaptive Histogram Equalization with Temporal Filtering[J]. IEEE Transactions on Consumer Electronics, 1998, 44(1):82- 87.

[13]Pece F, Kautz J. Bitmap Movement Detection: HDR for Dynamic Scenes[C]∥Proceedings of International Conference on Visual Media Production. London, UK, 2010, 10(2):1- 8.