1 引言

语音转换就是保持语义信息不变,仅改变一个说话人的语音个性特征(称为源说话人),使其听起来像是另一个说话人(称为目标说话人)的语音个性特征[1]。通过对语音转换的研究,可以进一步加强对语音相关参数的研究,探索人类的发音机理,控制语音信号的个性特征参数,对语音信号转换的研究可推动其他领域如:语音合成、语音识别、说话人识别等的发展,在文语转换、说话人伪装身份通信、多媒体娱乐、医学领域的语音增强、极低速率的语音编码方案[2]等领域有广泛应用价值。

语音转换最基本的内容有两个方面:韵律信息的转换和频谱特征参数的转换,国内外的研究主要集中在频谱参数的转换方法上,现有的绝大多数算法基于统计模型[3-5]。这些算法中很多需要源和目标说话人的足量平行语料,这带来了很多具体应用限制和问题,比如,训练的数据对两个说话人必须是相同的,训练的模型只能被应用到特定的一对组合,说话人的语料不充足,对齐时可能会出现的帧间错误匹配等等。21世纪以来,一些学者积极探索基于非平行语料的语音转换算法。其克服了平行语料语音转换的部分问题,如不需要相同的训练数据,模型可以被应用于多对一的组合。2006年,Geoffery Hinton在Science发表文章[6],提出基于深度信念网络(Deep Belief Networks, DBN)可使用非监督的逐层贪心训练算法,掀起了深度学习理论在语音转换上的研究浪潮[7- 8]。2015年香港中文大学的学者Lifa Sun利用自动语音识别系统对长短时记忆递归神经网络模型训练,实现了多对一的语音转换[9]。2016年,Hsu等人使用变分自编码器进行非平行语料的语音转换[10]。该方法将源语音经过编码网络生成服从高斯分布的语音编码,再经过解码网络将其重构为指定的目标语音,取得了较好的结果。

本文提出了一个增强变分自编码器,通过在变分自编码器中增加一个增强网络,由于增强网络是一个输入对应一个输出的,这使得增强变分自编码器有较好的去噪能力,从而可以部分克服变分自编码器的缺点,得到更好的语音转换效果。此外,本文还引入了循环训练方法以改善转换语音的目标倾向性。本文的其余部分安排如下:第2部分简要介绍基于变分自编码器的语音转换原理,第3部分阐述了如何改进变分自编码器,并介绍增强变分自编码器结构和训练流程,第4部分通过实验数据来验证本文提出的模型。最后,对本文的工作进行了总结。

2 变分自编码器

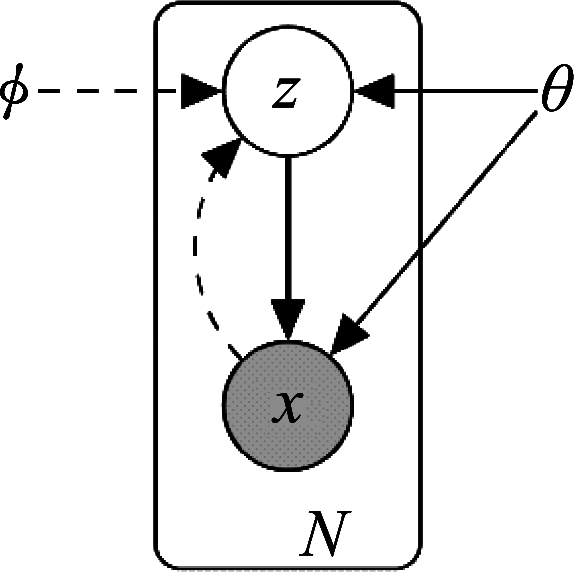

变分自编码器是一种生成模型,它将深度学习的观点与统计学习结合在一起。变分自编码器运用了贝叶斯的方法,它是在概率图模型上执行高效的近似推理和学习,并且涉及到对后验概率的近似优化[11]。

已知一个数据集![]() 包含N个独立同分布的变量x。假设变量x是由隐藏变量

包含N个独立同分布的变量x。假设变量x是由隐藏变量![]() 产生的,产生变量由两个随机过程组成:(1)产生变量

产生的,产生变量由两个随机过程组成:(1)产生变量![]() 记为

记为![]() 产生变量x,记为

产生变量x,记为![]() 此外,用

此外,用![]() 用来近似表示难以获得后验概率为

用来近似表示难以获得后验概率为![]() 该过程可以用图1表示。

该过程可以用图1表示。

图1 变量x产生过程

Fig.1 The process of generating a variable x

则有:

(1)

由于KL散度是大于0的,则有:

(2)

其中:

(3)

优化目标就是使得(1)中的logpθ(x(i))概率尽可能大。那么式(3)第一项应尽可能的小(KL散度不为负),第二项尽可能大。不妨假设![]() 服从标准正态分布,

服从标准正态分布,![]() 是变分自编码器的编码网络,其是将x编码成潜在变量

是变分自编码器的编码网络,其是将x编码成潜在变量![]() 它的优化目标是标准正态分布。

它的优化目标是标准正态分布。![]() 是变分自编码器的解码网络,其只需要尽可能地复原x就可以使式(3)的期望尽可能大。当训练完成时,从正态分布中随机采样经过解码网络就可以生成有意义的样本x。

是变分自编码器的解码网络,其只需要尽可能地复原x就可以使式(3)的期望尽可能大。当训练完成时,从正态分布中随机采样经过解码网络就可以生成有意义的样本x。

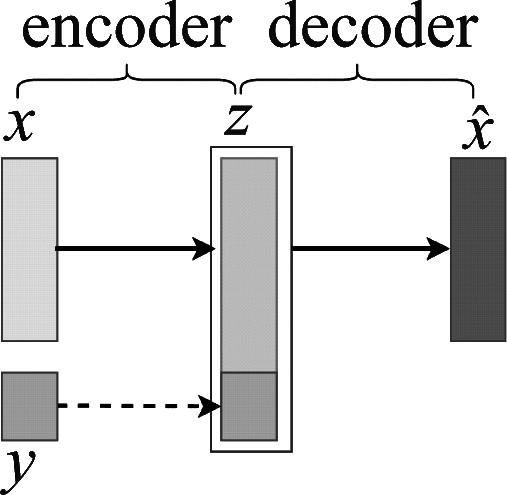

变分自编码器用编码网络(encoder)对样本x编码得到均值和方差,再对其进行高斯分布的随机采样,最后用解码网络(decoder)重建样本![]() 而解码网络的在训练时是多个输入对应同一个输出,这会导致解码网络的优化目标是不稳定的,从而使重建样本

而解码网络的在训练时是多个输入对应同一个输出,这会导致解码网络的优化目标是不稳定的,从而使重建样本![]() 包含噪声。Hsu等人使用变分自编码器对非平行的语料进行转换,其在潜在变量

包含噪声。Hsu等人使用变分自编码器对非平行的语料进行转换,其在潜在变量![]() 中加入了标签变量y,通过替换标签的方法以实现语音转换。该方法同样会存在变分自编码器的缺点,这使得转换后的语音存在噪声。其转换流程如图2所示。

中加入了标签变量y,通过替换标签的方法以实现语音转换。该方法同样会存在变分自编码器的缺点,这使得转换后的语音存在噪声。其转换流程如图2所示。

图2 变分自编码器语音转换过程

Fig.2 The process of voice conversion based on variation auto-encoder

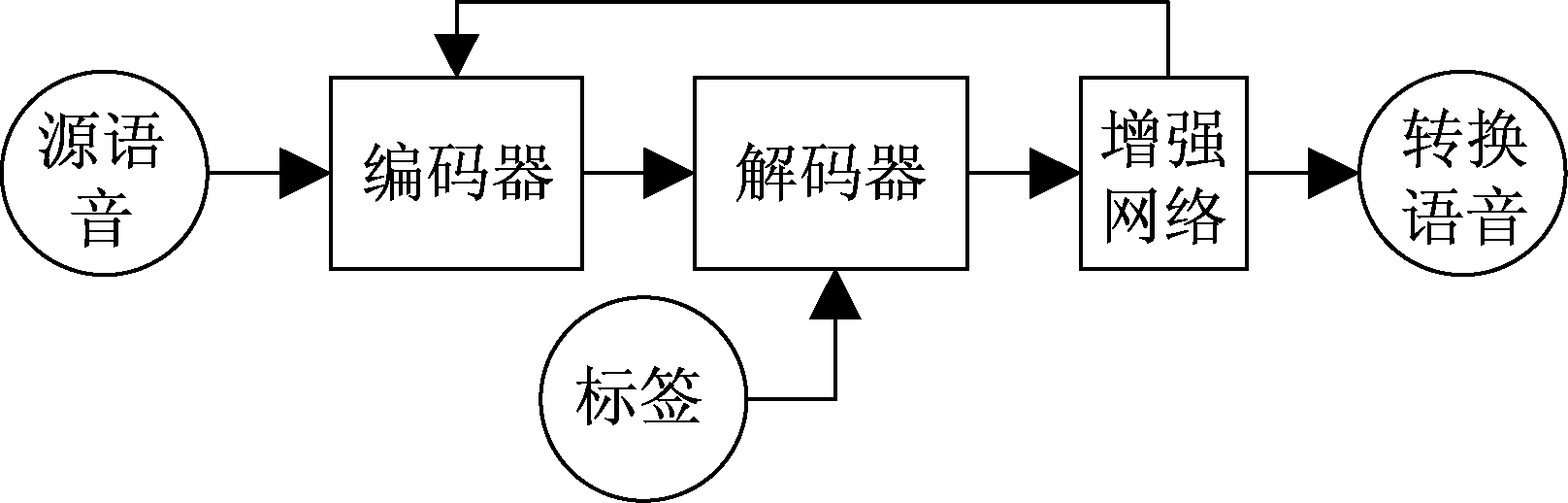

3 增强变分自编码器

增强变分自编码器由三部分组成:(1)编码网络:将源语音x映射到服从高斯分布的语音编码![]() 解码网络:将语音编码

解码网络:将语音编码![]() 重构为指定的目标语音x′。(3)增强网络:对x′进行优化,提高转换语音的质量。这三个部分串联在一起实现了端对端的训练,本文将该模型称为增强变分自编码器,如下图3中所示。

重构为指定的目标语音x′。(3)增强网络:对x′进行优化,提高转换语音的质量。这三个部分串联在一起实现了端对端的训练,本文将该模型称为增强变分自编码器,如下图3中所示。

图3 增强变分自编码器

Fig.3 Enhanced variation auto-encoder

3.1 增强网络

本文在变分自编码器上加入了增强网络,将编码网络的输出均值直接输入到解码网络中,再经过增强网络对转换后的语音进行一对一的训练,这使得增强网络的训练目标是稳定的,从而使增强网络拥有较好的去噪能力。

本文将源说话人记为s,目标说话人记为![]() 是源说话人所有帧的集合,

是源说话人所有帧的集合,![]() 是目标说话人帧的集合。其中Ns和Nt分别是源和目标说话人的总帧数。语音转换的目标是找到转换函数f(·)使得:

是目标说话人帧的集合。其中Ns和Nt分别是源和目标说话人的总帧数。语音转换的目标是找到转换函数f(·)使得:

(4)

首先,建立一个编码网络fØ(·),此时可以记输入xs,n,xt,m为xn。它将输入的帧编码成均值变量μ和方差变量ε有:

μ,ε=fØ(xn)

(5)

再将均值变量μ和方差变量ε经过高斯随机采样得到服从高斯分布的语音编码![]()

(6)

然后,建立一个说话人相关的解码网络fθ(·)。本文将表示说话人身份的标签yn与![]() 联合成向量

联合成向量![]() 以重建说话人相关的帧

以重建说话人相关的帧![]() 由yn决定其是

由yn决定其是![]() 还是

还是![]()

(7)

之后,把(5)中得到的均值变量μ与标签变量yn联合成向量(μ,yn)以重建源语音:

(8)

再建立一个增强网络fδ(·),将![]() 输入到增强网络中:

输入到增强网络中:

(9)

3.2 循环训练

Zhud等人在2018年提出了一个cyclegan网络用于图像翻译[12]。其基本思想是:如果图像A被成功翻译成假图像B′,那么假图像B′同样可以再次被翻译成A′,且A′与A是完全相同的。

本文的循环训练的方法采用了与此相似的优化策略:一段源语音x被转化成目标语音x′,当x′通过增强网络再次变为源语音x时,可以被无失真复原,以此为优化目标来更新增强网络的参数[13-14]。

将(8)中的标签变量yn替换成目标语音的标签![]() 再经过增强网络得到转换的目标语音

再经过增强网络得到转换的目标语音![]() 将转换的目标语音

将转换的目标语音![]() 依次经过(5),(8),(9)(公式(8)中标签为yn),最终得到语音

依次经过(5),(8),(9)(公式(8)中标签为yn),最终得到语音![]() 此时,理想的生成语音

此时,理想的生成语音![]() 可以无失真地复原源语音xn。这就是循环训练的过程,这可以增加转换语音的目标倾向性。

可以无失真地复原源语音xn。这就是循环训练的过程,这可以增加转换语音的目标倾向性。

语音转换阶段,将源语音的标签替换为目标语音的标签,增强变分自编码器会输出一个目标语音。

3.3 网络损失函数

本文使用KL散度来衡量编码网络的输出与理想高斯分布的距离:

(10)

解码网络的损失为:

(11)

增强网络的重建损失为:

(12)

增强网络的循环损失为:

(13)

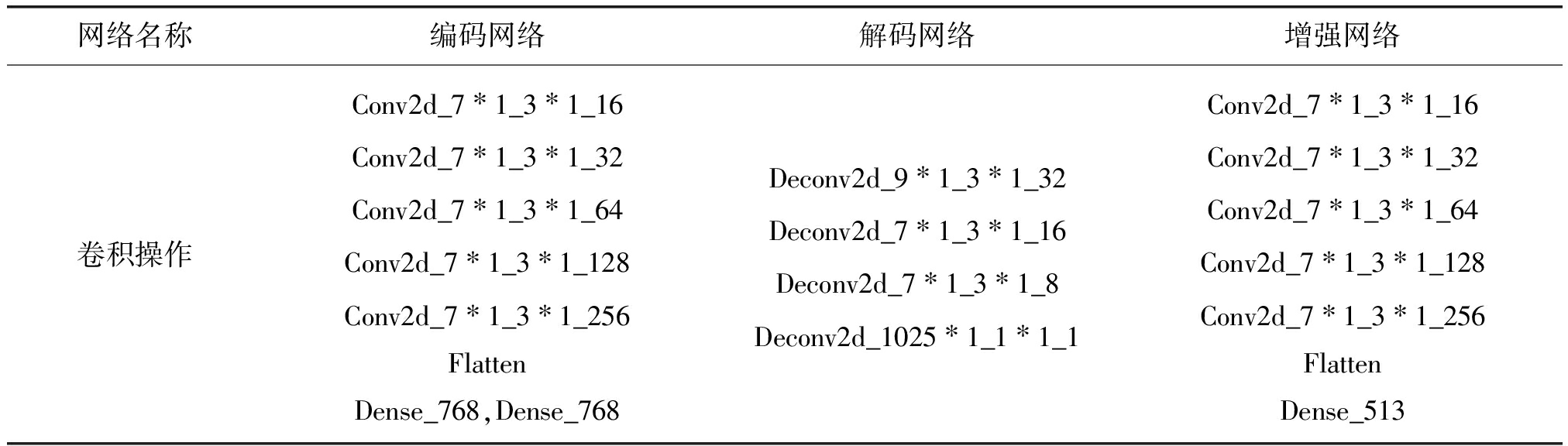

3.4 网络参数

为了表示方便,本文将一次卷积操作记为:卷积操作名称_卷积核大小_卷积步长_输出通道。如Conv2d_![]() 1_

1_![]() 1_16为二维卷积,卷积核大小为

1_16为二维卷积,卷积核大小为![]() 1,步长为

1,步长为![]() 1,输出通道为16的卷积操作。此外,二维卷积操作简记为:Conv2d,二位反卷积操作简记为Deconv2d,Flatten为将向量拉直。Dense_n表示全连接输出通道为n。从上到下依次卷积,同一行用逗号隔开表示该层有多个输出。如果无特殊说明,每一个二维卷积反卷积操作都会使用Batchnorm和激活函数LReLU。网络结构与参数如表1所示。

1,输出通道为16的卷积操作。此外,二维卷积操作简记为:Conv2d,二位反卷积操作简记为Deconv2d,Flatten为将向量拉直。Dense_n表示全连接输出通道为n。从上到下依次卷积,同一行用逗号隔开表示该层有多个输出。如果无特殊说明,每一个二维卷积反卷积操作都会使用Batchnorm和激活函数LReLU。网络结构与参数如表1所示。

表1 网络结构与参数

Tab.1 The structure and parameters of the network

网络名称编码网络解码网络增强网络卷积操作Conv2d_7∗1_3∗1_16Conv2d_7∗1_3∗1_32Conv2d_7∗1_3∗1_64Conv2d_7∗1_3∗1_128Conv2d_7∗1_3∗1_256FlattenDense_768,Dense_768Deconv2d_9∗1_3∗1_32Deconv2d_7∗1_3∗1_16Deconv2d_7∗1_3∗1_8Deconv2d_1025∗1_1∗1_1Conv2d_7∗1_3∗1_16Conv2d_7∗1_3∗1_32Conv2d_7∗1_3∗1_64Conv2d_7∗1_3∗1_128Conv2d_7∗1_3∗1_256FlattenDense_513

注:解码网络最后一层不使用激活函数和Batchnorm操作。

3.5 训练流程

第1步:用![]() 来更新编码网络和解码网络的参数。

来更新编码网络和解码网络的参数。

第2步:用![]() 更新增强网络的参数。

更新增强网络的参数。

第3步:用![]() 更新增强网络的参数。

更新增强网络的参数。

不断循环,当所有损失函数的值不再有明显变化则停止训练。

4 实验结果与分析

本文使用CMU ARCTIC语料库[15]进行跨性别语音转换实验(男性对女性,女性对男性)。语音信号在16 kHz单声道采样,每一帧的长度为1024,帧移为256。从CMU ARCTIC语料库用选取一个男生和女生的声音,分别有1132条语音,每段语音时长约为3 s。其中一半划分为非平行的训练语音,另一半划分为测试语音。STRAIGHT(Speech Transformation And Representation and Interpolation Using Weighted Spectrogram,自适应加权谱内插)工具包提取语音参数并合成语音[16]。

4.1 客观评价

本文使用谱失真作为语音转换效果的客观评价标准,记两段语音在频谱上的DTW(Dynamic Time Warping,动态时间归整)距离为![]() 目标语音的帧数为n,谱失真为Sd(Spectral distortion)。则有:

目标语音的帧数为n,谱失真为Sd(Spectral distortion)。则有:

(14)

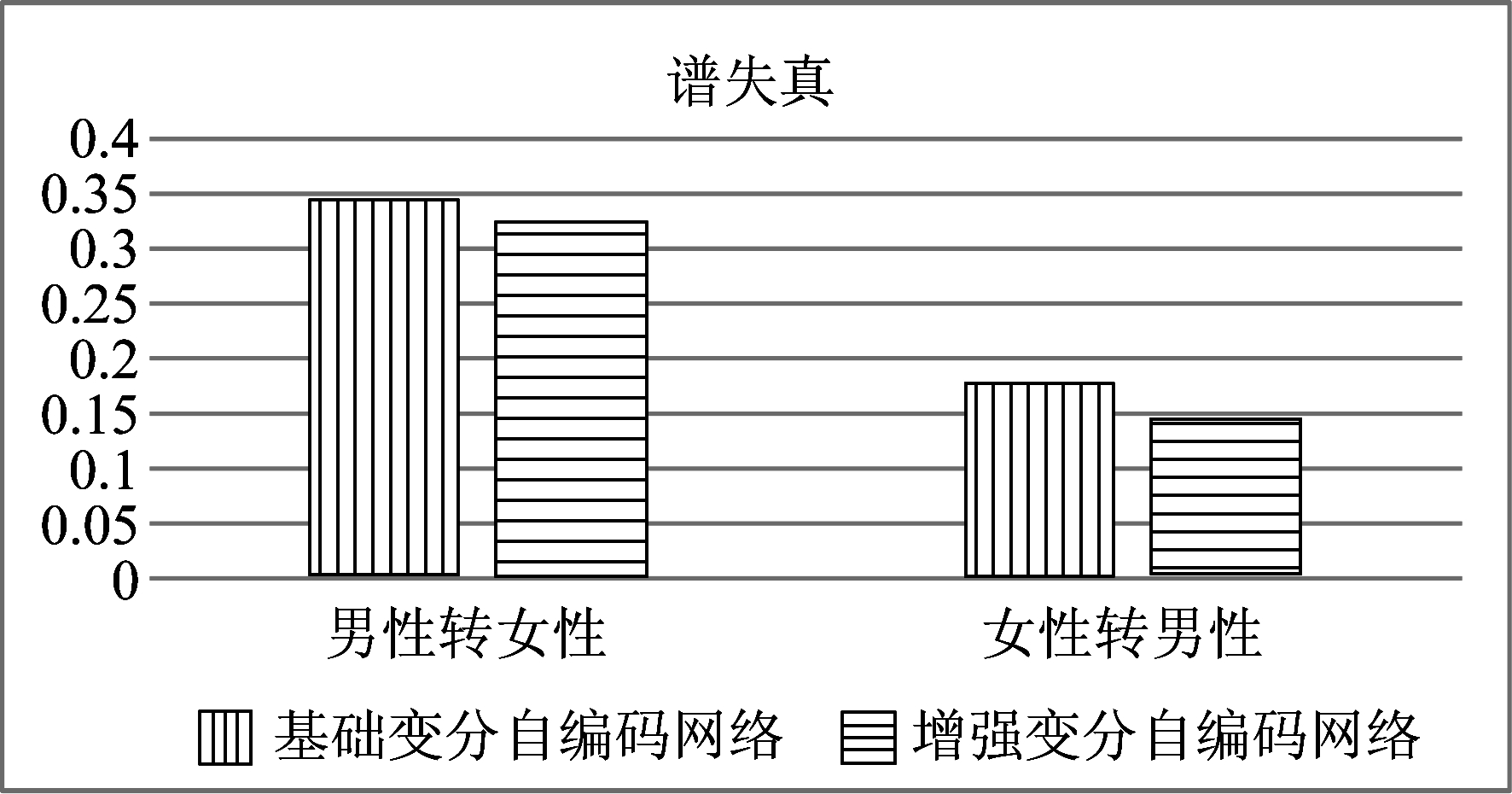

此外,需要对目标语音和转换语音做归一化处理,以减少语音强度对谱失真的影响。将测试集上每一段语音的谱失真取平均值得到平均谱失真。谱失真数值越小表示该方法越好。结果如图4所示。

图4 谱失真测度

Fig.4 Spectral distortion measure

由图4可以看出,与变分自编码器语音转换系统相比,本文的语音转换系统在谱失方面有所改善。且女性转男性比男性转女性效果更好,这也与听觉效果是一致的。

4.2 主观评价

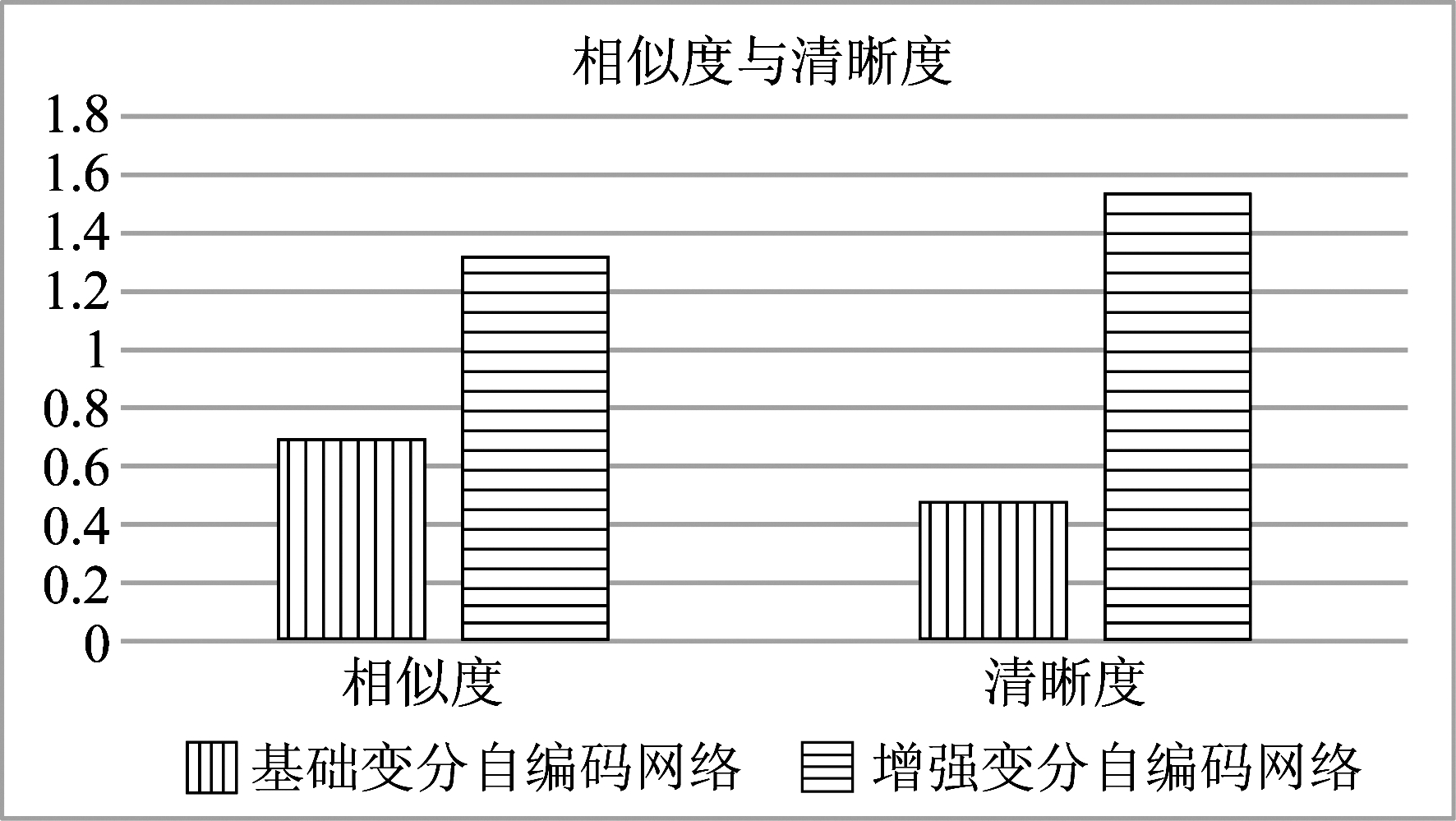

首先从测试集中随机抽取10个样本,5个为男性转女性,5个为女性转男性。每一个样本包含4个文件:源语音,目标语音,转换语音T1,转换语音T2。T1,T2是被随机打乱的,一个是本文的转换语音,另一个是变分自编码器转换的语音。每个测试者需要将T1,T2与目标语音比较,T1,T2哪一个更接近目标语音,T1,T2哪一个清晰度更好。测试者有三个选项供选择:T1更好,T2更好,T1和T2一样好。本文记优胜的方法得2分,失败的方法得0分,两种方法一样好各得1分。主观评价分数越高,那么该方法越好。参与本次测试的共有17人。两种方法得到的平均分如图5所示。

图5 相似度与清晰度比较

Fig.5 Comparison of similarity and clearness

由图5可以看出,本文的方法在相似度和清晰度指标上都优于变分自编码器,在清晰度方面改善尤为明显。

此外,可以在https:∥github.com/huangguojie880/EVAE听到变分自编码器与增强变分自编码器的语音转换效果。

5 结论

本文提出了一个基于增强变分自编码器的非平行语料语音转换系统,对变分自编码器做出了进一步的改进。从跨性别语音转换的客观评价标准和主观评价标准上看,本文的改进工作颇有成效。但是,实验得到的语音转换效果与理想的非平行语料语音转换还存在一定的差距。增强变分自编码器可以克服变分自编码器本身的一些缺点,这种改进可以扩展到其他领域,如图像处理中。

[1] 李力,俞一彪.采用超音段韵律特征联合短时频谱的语音转换[J].信号处理,2012, 28(2): 289-294.

Li Li,Yu Yibiao.Voice Conversion Using Spectrum with Super-Segment Prosody Features[J]. Signal Processing, 2012, 28(2): 289-294.(in Chinese)

[2] Xu N, Yang Z, Zhu W P. Modeling Articulatory Movements for Voice Conversion Using State-Space Model[C]∥International Conference on Natural Computation. IEEE Computer Society, 2009:236-240.

[3] 孙新建,张雄伟,杨吉斌,等.基于隐变量模型的语音转换方法研究[J].信号处理,2012, 28(3): 344-351.

Sun Xinjian,Zhang Xiongwei, Yang Jibin, et al. Voice Conversion Using Latent Variable Model[J]. Signal Processing, 2012, 28(3): 344-351.(in Chinese)

[4] 宋鹏,王浩,赵力.采用模型自适应的语音转换方法[J].信号处理,2013, 29(10): 1294-1299.

Song Peng, Wang Hao, Zhao Li. Voice Conversion Method Based On Model Adaptation[J]. Journal of Signal Processing, 2013, 29(10): 1294-1299.(in Chinese)

[5] 马振,张雄伟,杨吉斌.基于语音个人特征信息分离的语音转换方法研究[J].信号处理,2013, 29(4): 513-519.

Ma Zhen, Zhang Xiongwei, Yang Jibin. A Speech Conversion Method Based on the Separation of Speaker-specific Characteristics[J]. Journal of Signal Processing, 2013, 29(4): 513-519.(in Chinese)

[6] Hinton G E, Salakhutdinov R R. Reducing the dimensionality of data with neural networks[J]. Science, 2006, 313(5786): 504-507.

[7] Nakashika T, Takashima R, Takiguchi T, et al. Voice conversion in high-order eigen space using deep belief nets[C]∥Interspeech, 2013: 369-372.

[8] Nakashika T, Takiguchi T, Ariki Y. Voice conversion using RNN pre-trained by recurrent temporal restricted Boltzmann machines[J]. IEEE/ACM Transactions on Audio, Speech and Language Processing (TASLP), 2015, 23(3): 580-587.

[9] Sun Lifa, Li Kun, Wang Hao, et al. Phonetic posteriorgrams for many-to-one voice conversion without parallel data training[C]∥IEEE International Conference on Multimedia and Expo. IEEE, 2016:1- 6.

[10] Hsu C C, Hwang H T, Wu Y C, et al. Voice conversion from non-parallel corpora using variational auto-encoder[C]∥Signal and Information Processing Association Annual Summit and Conference (APSIPA), 2016 Asia-Pacific. IEEE, 2016: 1- 6.

[11] Kingma D P, Welling M. Auto-encoding variational bayes[J]. ArXiv Preprint ArXiv:1312.6114, 2013.

[12] Zhu J Y, Park T, Isola P, et al. Unpaired image-to-image translation using cycle-consistent adversarial networks[J]. ArXiv Preprint ArXiv:1703.10593, 2017.

[13] Yi Z, Zhang H, Tan P, et al. Dualgan: Unsupervised dual learning for image-to-image translation[J]. ArXiv Preprint, 2017.

[14] Kim T, Cha M, Kim H, et al. Learning to Discover Cross-Domain Relations with Generative Adversarial Networks[C]∥International Conference on Machine Learning, 2017: 1857-1865.

[15] Kominek J, Black A W. The CMU Arctic speech databases[J]. Proc of Isca Speech Synthesis Workshop, 2004, 99(4):223-224.

[16] Kawahara H. Speech representation and transformation using adaptive interpolation of weighted spectrum: vocoder revisited[C]∥IEEE International Conference on Acoustics, Speech, and Signal Processing. IEEE Computer Society, 1997:1303-1306.